目录

词汇表征?

- 词嵌入:自动理解一些类似的词

- 比如男人对女人

- 国王对王后等

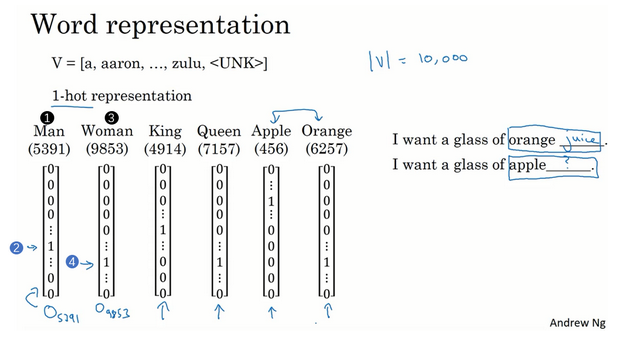

- 词语表示:独热编码

- 词语表示:特征化

- 词嵌入可视化:

使用词嵌入

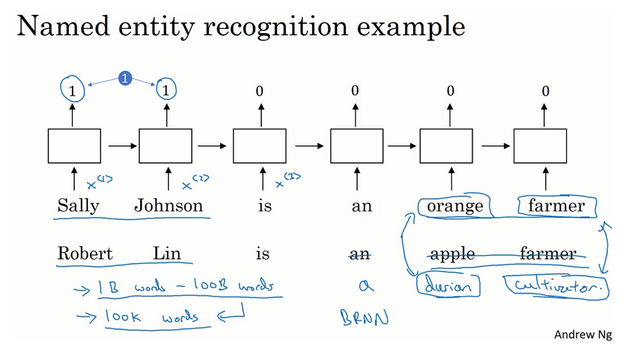

- 例子:命名实体识别

- 为什么有这个效果?

- 学习词嵌入的算法会考察非常大的文本集

- 词嵌入做迁移学习:

- 词嵌入 vs 人脸编码:

- 词嵌入:只有固定的词汇表,一些没出现过的单词记为未知

- 人脸编码:用向量表示人脸,未来涉及到海量的人脸照片

词嵌入的特性

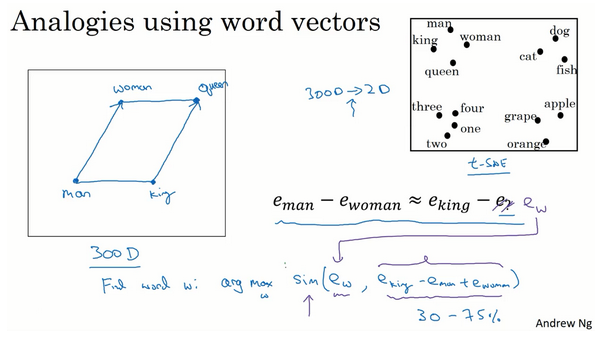

- 实现类比推理

- 问题形式如:如果man对应woman,那么king对应什么?

- 对应问题转换为向量表示

- 算法表示:

- 相似度:

嵌入矩阵

- 算法:学习词嵌入 =》学习一个嵌入矩阵

- 嵌入矩阵E x 独热编码 = 词向量e

- 实际中:矩阵相乘效率低下,会有专门的函数查找矩阵E的某列。因为这个时候E是已经求解出来的,不用再通过相乘的方式去获得某个词的特征表示,而是直接索引获取。

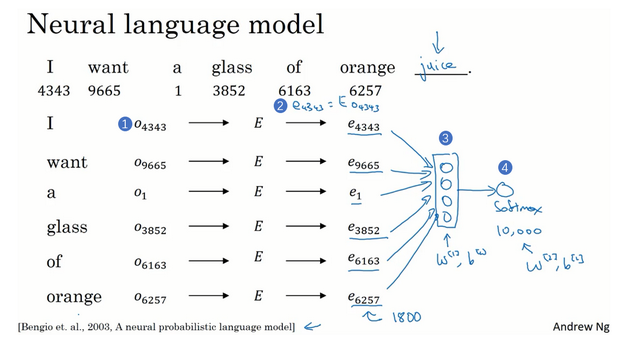

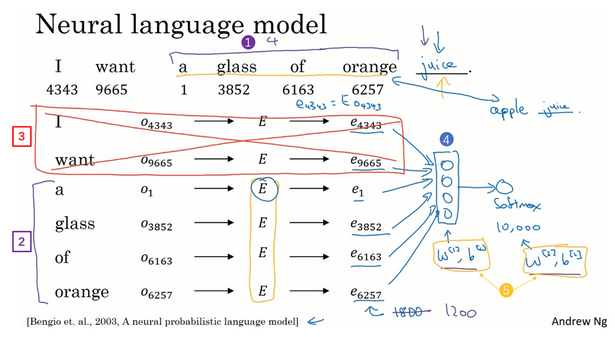

学习词嵌入

- 学习词嵌入:有难的算法,也有简单的算法

- 模型流程:

- 输入不一样长?

- 其他算法:

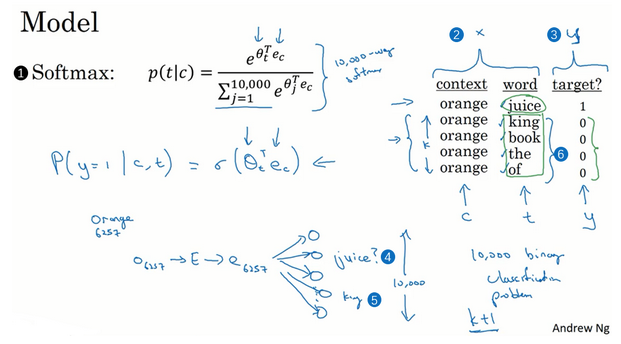

Word2Vec

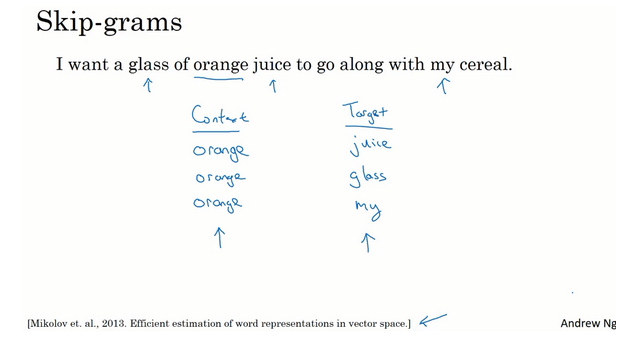

- Skip-Gram:

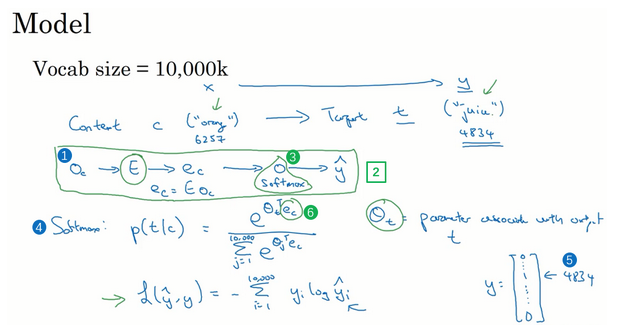

- 模型:

- 问题:

- 上下文c进行采样?

- 为什么要采样?构建训练集

- 一旦上下文c确定了,目标词t就是c正负10词距内进行采样了

- 方案1:对语料库均匀且随机采样。有些词比如the、an等会出现得很频繁。

- 方案2:不同的分级来平衡更常见的词和不那么常见的词。

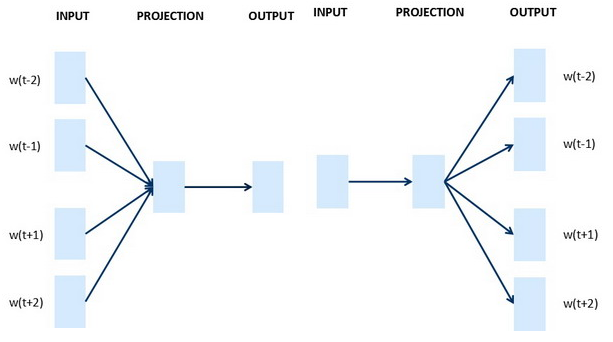

- Skip-Gram vs CBOW:

- 参考这里word2vec-pytorch/word2vec.ipynb看两种模型的具体实现

定义的模型:

class CBOW(nn.Module):

def __init__(self, vocab_size, embd_size, context_size, hidden_size):

super(CBOW, self).__init__()

self.embeddings = nn.Embedding(vocab_size, embd_size)

self.linear1 = nn.Linear(2*context_size*embd_size, hidden_size)

self.linear2 = nn.Linear(hidden_size, vocab_size)

def forward(self, inputs):

embedded = self.embeddings(inputs).view((1, -1))

hid = F.relu(self.linear1(embedded))

out = self.linear2(hid)

log_probs = F.log_softmax(out)

return log_probs

class SkipGram(nn.Module):

def __init__(self, vocab_size, embd_size):

super(SkipGram, self).__init__()

self.embeddings = nn.Embedding(vocab_size, embd_size)

def forward(self, focus, context):

embed_focus = self.embeddings(focus).view((1, -1))

embed_ctx = self.embeddings(context).view((1, -1))

score = torch.mm(embed_focus, torch.t(embed_ctx))

log_probs = F.logsigmoid(score)

return log_probs

负采样

- 新监督学习问题:给定一对单词,预测这是否是一对上下文词-目标词(context-target)

- 样本:

- 训练:

- 监督学习算法

- 输入:x,一对对的词

- 预测:y,这对词会不会一起出现,还是随机取到的,算法就是要区分这两种采样方式。

- K值大小:小数据集取5-20,大数据集取小一点,更大的数据集取2-5,这里k=4

- 模型:

- 如何选取负样本?

- 上面说了:从字典里面随机选取?

- 方案1:根据词出现的频率进行采样。the、an这类词会很高频。

- 方案2:均匀随机抽样,对于英文单词的分布非常没有代表性。

- 方案3:根据这个频率值来选取,\(P(w_i)=\frac{f(w_i)^{\frac{3}{4}}}{\sum_{j=1}^{100000}f(w_i)^{\frac{3}{4}}}\)。通过词频的3/4次方的计算,使其处于完全独立的分布和训练集的观测分布两个极端之间。

对于skim-gram和CBOW两种模型,根据给定的text数据生成训练数据的方式:

# context window size is two

def create_cbow_dataset(text):

data = []

for i in range(2, len(text) - 2):

context = [text[i - 2], text[i - 1],

text[i + 1], text[i + 2]]

target = text[i]

data.append((context, target))

return data

def create_skipgram_dataset(text):

import random

data = []

for i in range(2, len(text) - 2):

data.append((text[i], text[i-2], 1))

data.append((text[i], text[i-1], 1))

data.append((text[i], text[i+1], 1))

data.append((text[i], text[i+2], 1))

# negative sampling

for _ in range(4):

if random.random() < 0.5 or i >= len(text) - 3:

rand_id = random.randint(0, i-1)

else:

rand_id = random.randint(i+3, len(text)-1)

data.append((text[i], text[rand_id], 0))

return data

cbow_train = create_cbow_dataset(text)

skipgram_train = create_skipgram_dataset(text)

print('cbow sample', cbow_train[0])

print('skipgram sample', skipgram_train[0])

GloVe词向量

- GloVe:

- 模型:

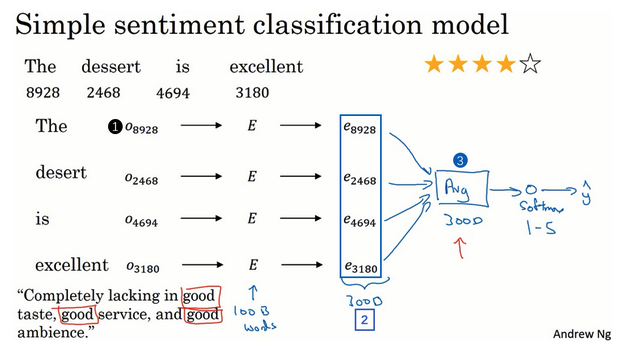

情感分类

- 情感分类任务:

- 看一段文本,分辨这个人是否喜欢他们在讨论的这个东西

- 挑战:标记的训练集没有那么多

- 例子:

- 餐馆评价

- x:评价的一段话,y:给出的几颗星(评价等级)

- 简单模型:

- 某一个评价作为例子

- 对于此评价的每个单词,通过独热编码向量和嵌入矩阵转换为嵌入向量

- 嵌入向量相加取平均。这个能保证最后取得维度是一样的,比如次特征向量是300维的,那么取平均之后还是300维的,且不受输入句子长度的影响。

- 平均后的向量输入softmax分类器

- 输出y:5个可能的结果的概率值

- 此处:【平均值运算单元】,把所有单词的意思给平均起来使用

- 问题:没有考虑词序,也就是一句话如果打乱顺序,最后的词向量平均表示是一样的,但是可能意思是不同的

- RNN版本模型:

- 每个单词通过独热编码向量和嵌入矩阵转换为嵌入向量

- 嵌入向量作为时序序列传到RNN模型中

- 属于多对一的模型,在最后一步才计算一个特征表示,用于预测输出

- 此时就考虑了句子的具体含义,效果更好

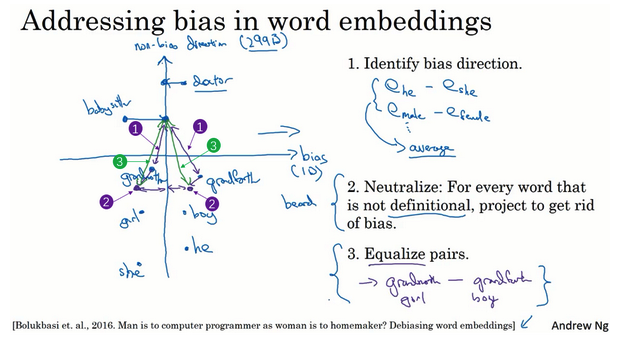

词嵌入除偏

- bias:是指学习到的东西存在性别、种族、性取向等方面的偏见。因为现在这些模型越来越多的参与到决策,所以需要排除这些偏见的影响。

- 例子:

- 可能学到man是程序员,但是woman是家庭主妇,这就是带有性别偏见的

- 可能学到man是程序员,但是woman是家庭主妇,这就是带有性别偏见的

- 消除偏见:

- 鉴定bias:比如有一些SUV算法,对一些词语进行聚类,不同的维度(偏见、不偏见)。如果在偏见轴大的,就是属于有偏见的。

- 中和:对于不确切的词可以处理一下,避免偏见。

- 均衡:有一些词保证它们只在一个维度是有差异的,比如grandmothers和grandfathers只在性别有差异,其他特征保证相等(在坐标抽上的距离是相当的)。

参考

If you link this blog, please refer to this page, thanks!

Post link:https://tsinghua-gongjing.github.io/posts/sequence-models-5-NLP-word-embediings.html

Previous:

爬虫抓取微博内容

Next:

【5-3】序列模型和注意力机制

Latest articles

Links

- ZhangLab , RISE database , THU life , THU info

- Data analysis: pandas , numpy , scipy

- ML/DL: sklearn , sklearn(中文) , pytorch

- Visualization: seaborn , matplotlib , gallery

- Github: me