目录

经典网络

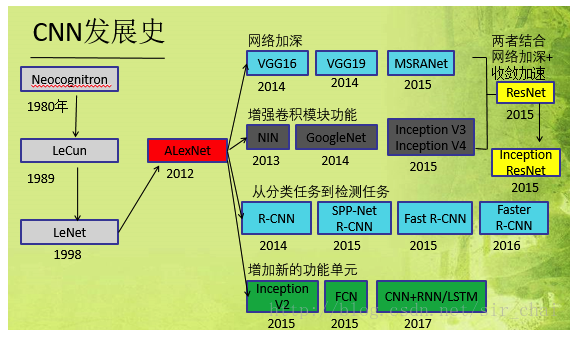

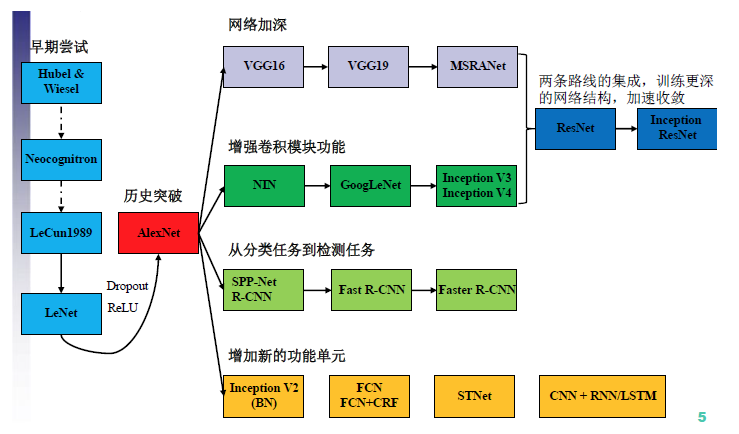

- CNN网络的发展历史:

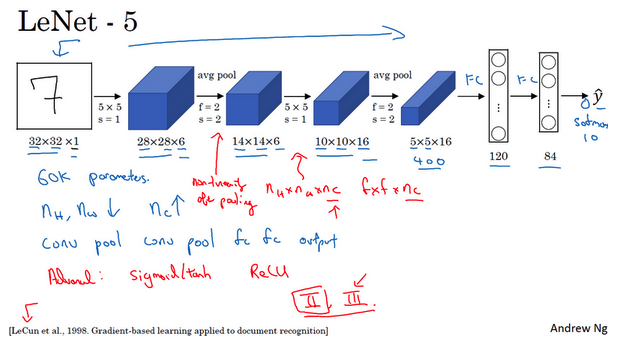

- LeNet-5:

- 识别手写数字

- 针对灰度图像进行训练

- 大约6万个参数

- 模式:一个或多个卷积层后面跟着一个池化层,然后又是若干个卷积层再接一个池化层,然后使全连接层,最后是输出。这种排列方式很常用。

- 非线性处理:使用sigmoid函数和tanh函数,而不是ReLU函数

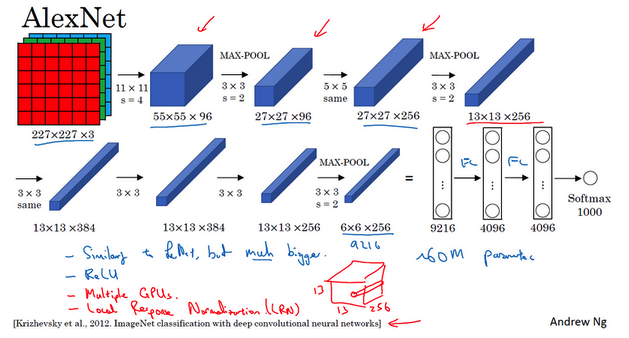

- AlexNet:

- 以第一作者Alex Krizhevsky的名字命名

- 与LeNet-5很多相似处,大得多

- 含有约6000万个参数

- 使用ReLU激活函数,使得其表现更加出色的另一个原因

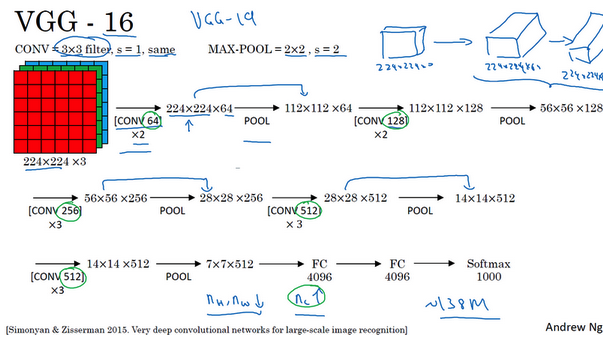

- VGG-16:

- 没有特别多的超参数

- 只需要专注于构建卷积层的简单网络

- 优点是简化了神经网络结构(相对一致的网络结构)

- 缺点是:需要训练的特征数量非常巨大

- 包含16个卷积层和全连接层

- 约1.38亿个参数,但是结构不复杂

- 亮点:随着网络的加深,图像的高度和宽度都在以一定的规律不断缩小,每次池化后刚好缩小一半,而通道数量在不断增加,而且刚好也是在每组卷积操作后增加一倍。

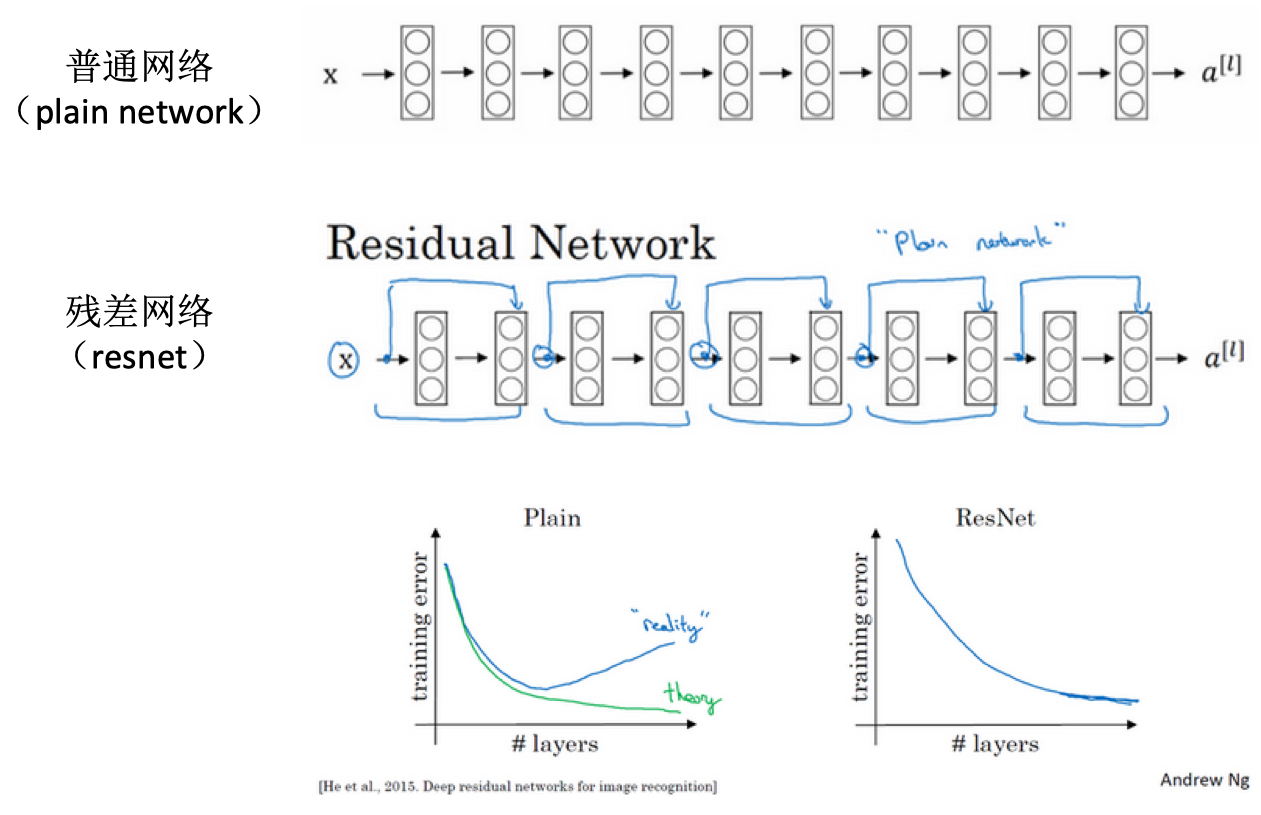

残差网络

- 神经网络训练难:非常深的神经网络训练困难,存在梯度消失和梯度爆炸

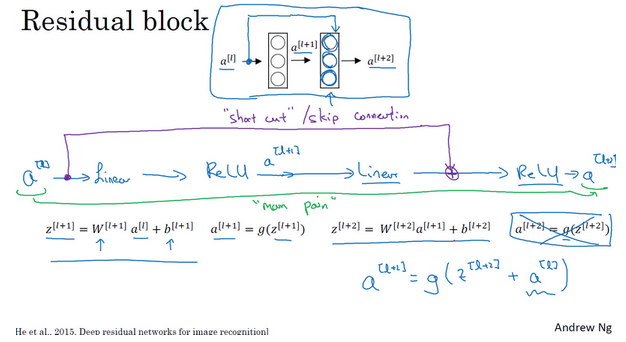

- 跳跃连接:从某一层网络层获得激活,然后迅速反馈给另外一层,甚至是神经网络的更深层。比如下面的a(l)跳过一层或者好几层,从而将信息传递到神经网络的更深层。

- 残差块:

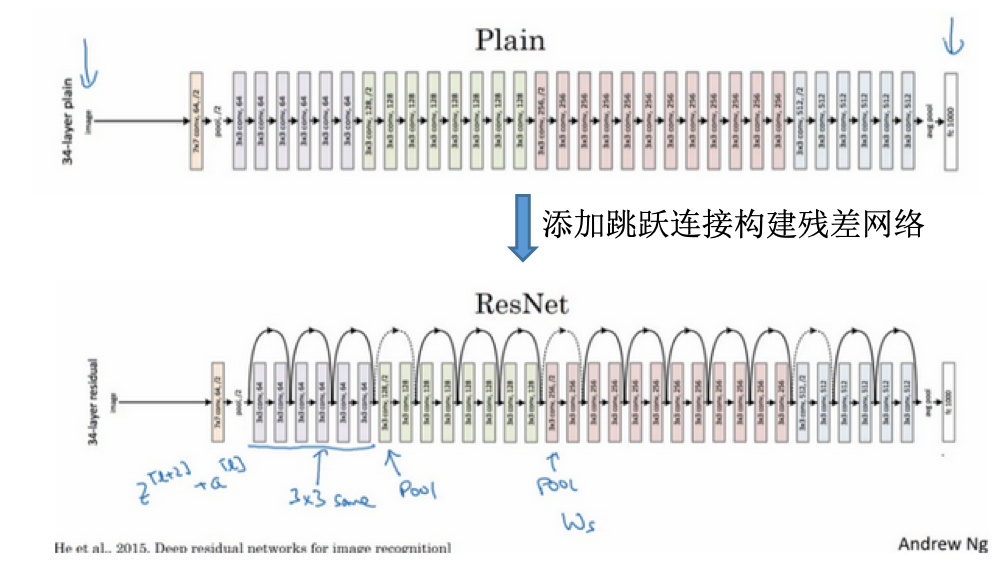

- ResNet vs plain net:

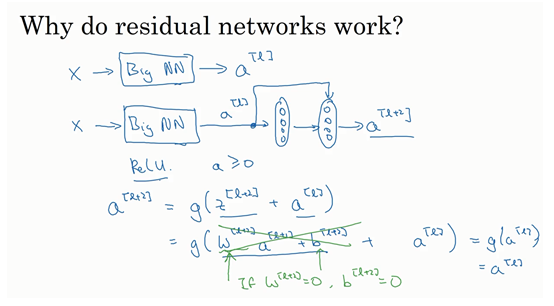

- 为什么残差网络有用?

- 论文中的网络:

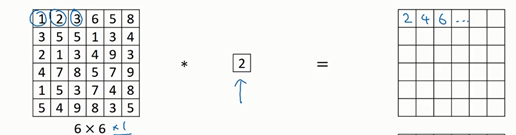

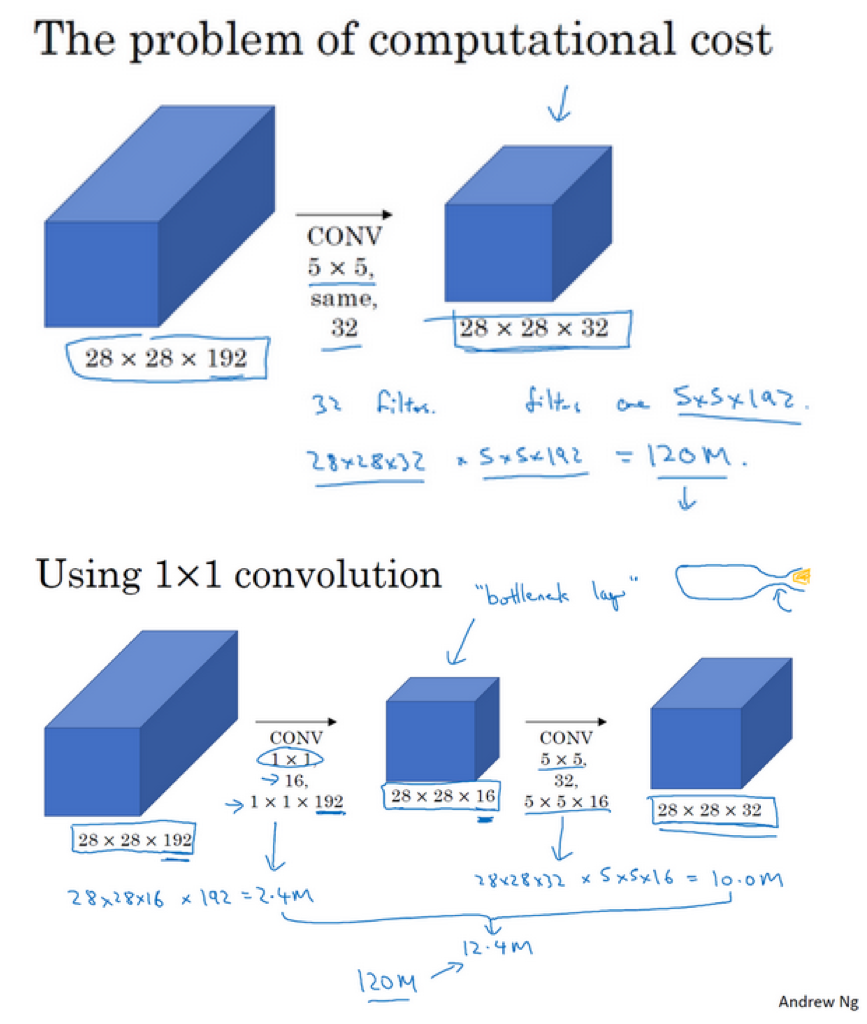

网络中的网络及1x1卷积

- 1x1卷积于二维:

- 1x1卷积于三维:

- 压缩作用:

- 池化层:压缩高度和宽度。经过池化之后,图像的大小变成原来的一半,并一直减小

- 1x1卷积:压缩通道数。当每个过滤器的深度和原图像深度一样时,但是使用不同的过滤器数目,可以使得输出的通道数变化(变大变小等)。

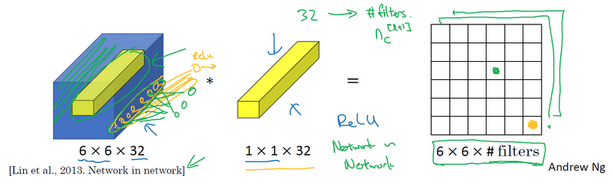

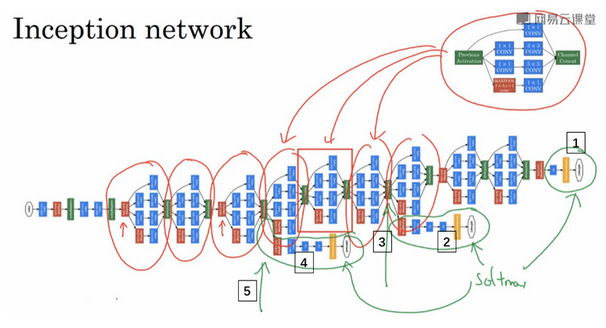

谷歌Inception网络

- 为什么出现Inception网络?

- 参考这里的背景介绍

- CNN结构演化图:

- GoogLeNet出来之前:对于网络的改进是,网络更深(层数),网络更宽(神经元数目)

- 缺点:(1)参数太多,容易过拟合;(2)网络越大计算复杂度越大;(3)网络越深,会出现梯度消失,难以优化

- 解决:增加网络深度和宽度的同时减少参数,于是就有了Inception。

- Inception:

- 盗梦空间的电影名称

- 替你决定过滤器的大小选择多大

- Inception模块:

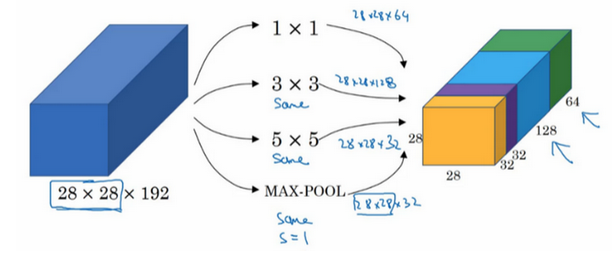

- 计算成本:

- Inception网络:

- 其他版本:引入跳跃连接等

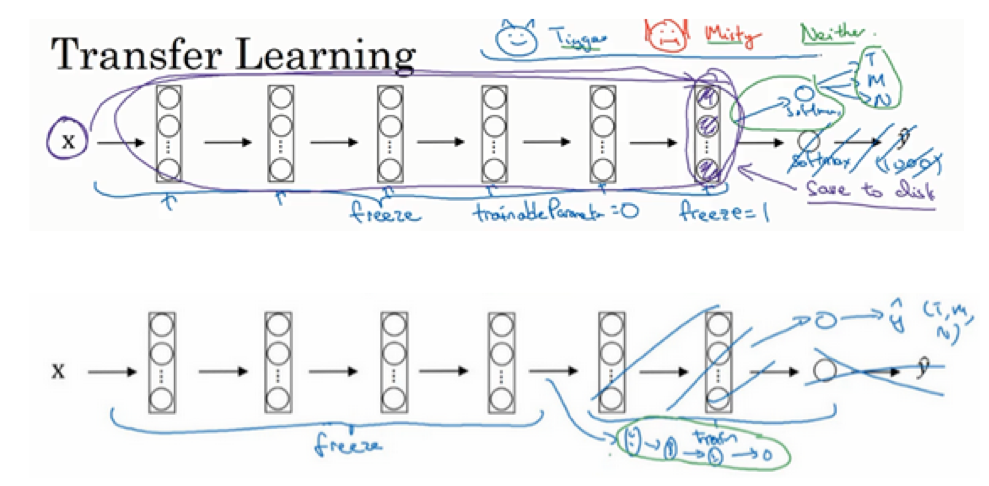

迁移学习

- 大型的数据集:

- ImageNet

- MS COCO

- Pascal

- 研究者已经在这些数据上训练过他们的算法,训练花费长时间多GPU

- 迁移学习:

- 下载开源的权重参数,当做一个很好的初始化用在自己的神经网络上

- 用迁移学习把公共的数据集的知识迁移到自己的问题上

- 值得考虑,除非你有一个极其大的数据集和非常大的计算量预算来从头训练你的网络

- 例子:

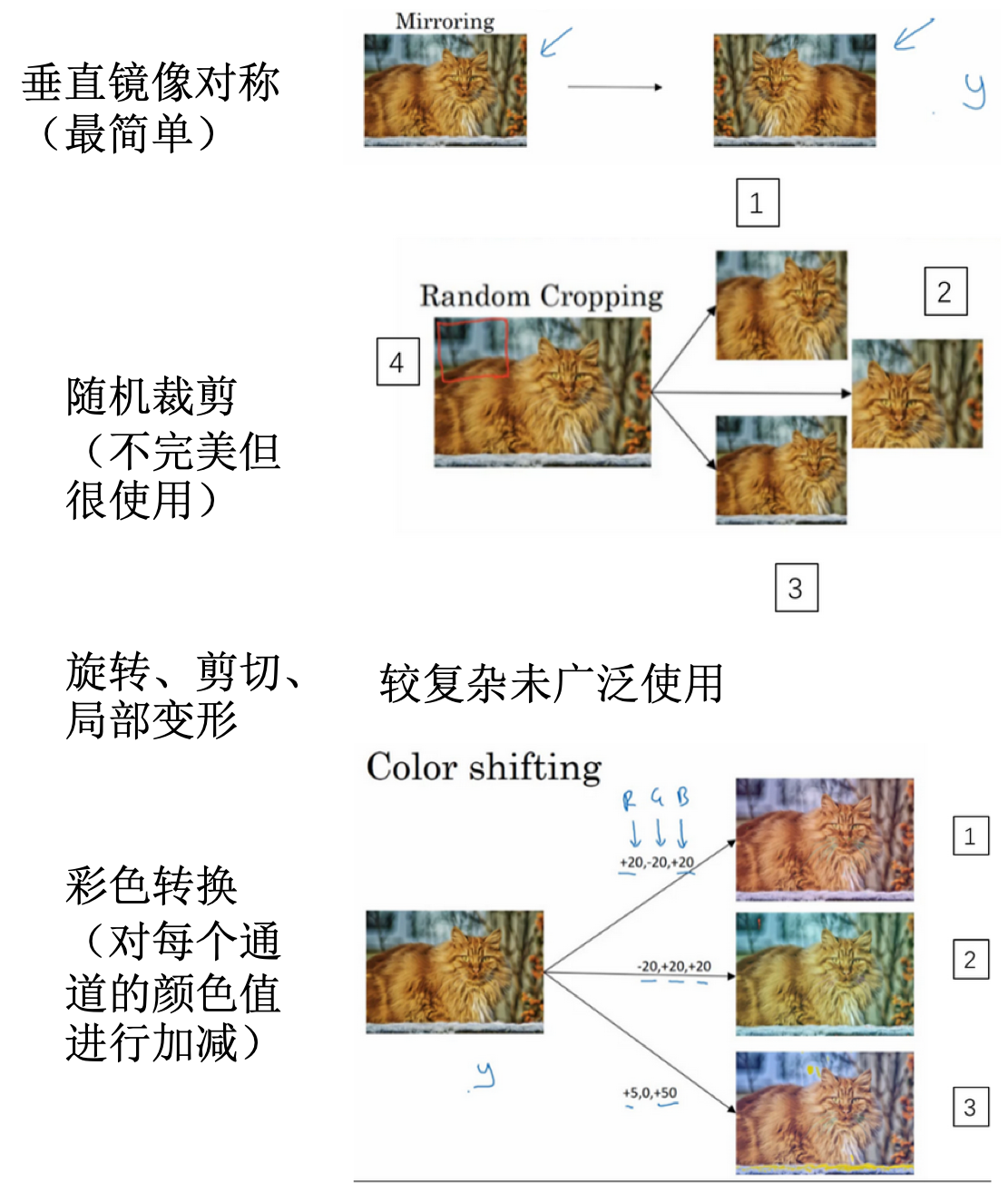

数据增强

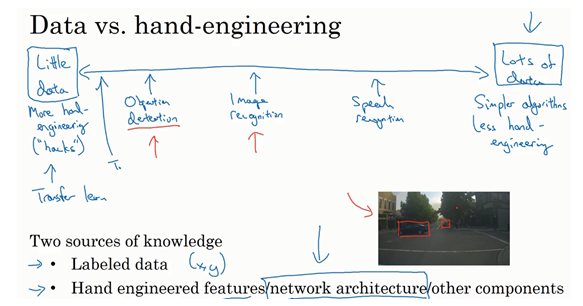

计算机视觉现状

- 机器学习问题:介于少量数据和大量数据范围之间

- 知识或者数据的来源:

- 基准测试技巧:

- 集成。比如在多个网络中训练,取其平均结果。

- multi-scrop:裁剪选取一个中心区域,取其四个角得到四个样本,其实还是属于样本扩充。对于计算量要求很高。

- 需要耗费大量的计算,不是服务于客户的,只是为了在基准测试中取的好的效果

参考

If you link this blog, please refer to this page, thanks!

Post link:https://tsinghua-gongjing.github.io/posts/CNN-4-case-study.html

Latest articles

Links

- ZhangLab , RISE database , THU life , THU info

- Data analysis: pandas , numpy , scipy

- ML/DL: sklearn , sklearn(中文) , pytorch

- Visualization: seaborn , matplotlib , gallery

- Github: me