08: Neural Networks - Representation

- 非线性问题:线性不可分,增加各种特征使得可分。比如根据图片检测汽车(计算机视觉)。当特征空间很大时,逻辑回归不再适用,而神经网络则是一个更好的非线性模型。

- 神经网络:想要模拟大脑(不同的皮层区具有不同的功能,如味觉、听觉、触觉等),上世纪80-90年代很流行,90年达后期开始没落,现在又很流行,解决很多实际的问题。

- 神经网络:

- cell body, input wires (dendrities, 树突), output wire (axon,轴突)

- 逻辑单元:最简单的神经元。一个输入层,一个激活函数,一个输出层。

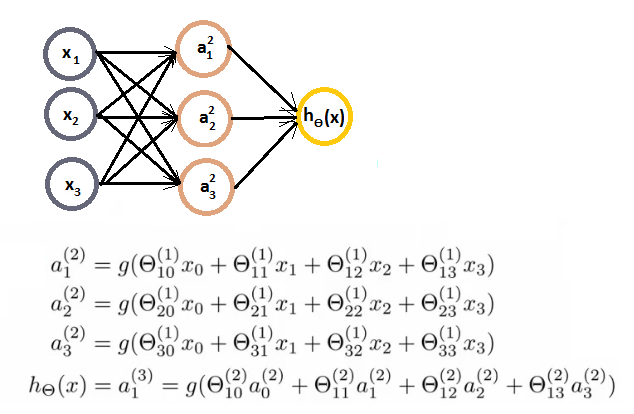

- 神经网络:激活函数,权重矩阵:

- 输入层,输出层,隐藏层

- ai(j) - activation of unit i in layer j

- 前向传播:向量化实现,使用向量表示每一层次的输出。

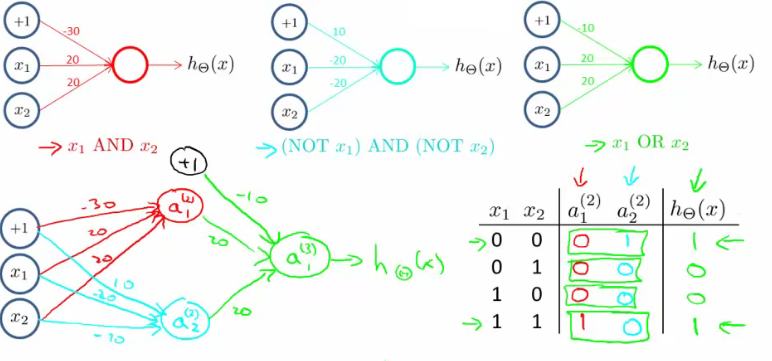

- 使用神经网络实现逻辑符号(逻辑与、逻辑或,逻辑和):

- 实现的是逻辑,而非线性问题,所以神经网络能很好的用于非线性问题上。

- 下面的是实现 XNOR (NOT XOR):

- 多分类问题:one-vs-all

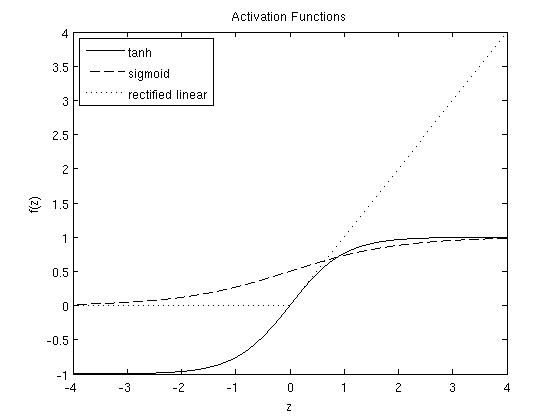

- 常见的激活函数:

- sigmoid: \(f(z) = \frac{1}{1+\exp(-z)}\)

- tanh (hyperbolic tangent): \(f(z) = \tanh(z) = \frac{e^z - e^{-z}}{e^z + e^{-z}}\)

- reLU (rectified linear): \(f(z) = \max(0,x)\)

If you link this blog, please refer to this page, thanks!

Post link:https://tsinghua-gongjing.github.io/posts/CS229-08-neural-network.html

Previous:

Confusion matrix

Next:

神经网络

Latest articles

Links

- ZhangLab , RISE database , THU life , THU info

- Data analysis: pandas , numpy , scipy

- ML/DL: sklearn , sklearn(中文) , pytorch

- Visualization: seaborn , matplotlib , gallery

- Github: me